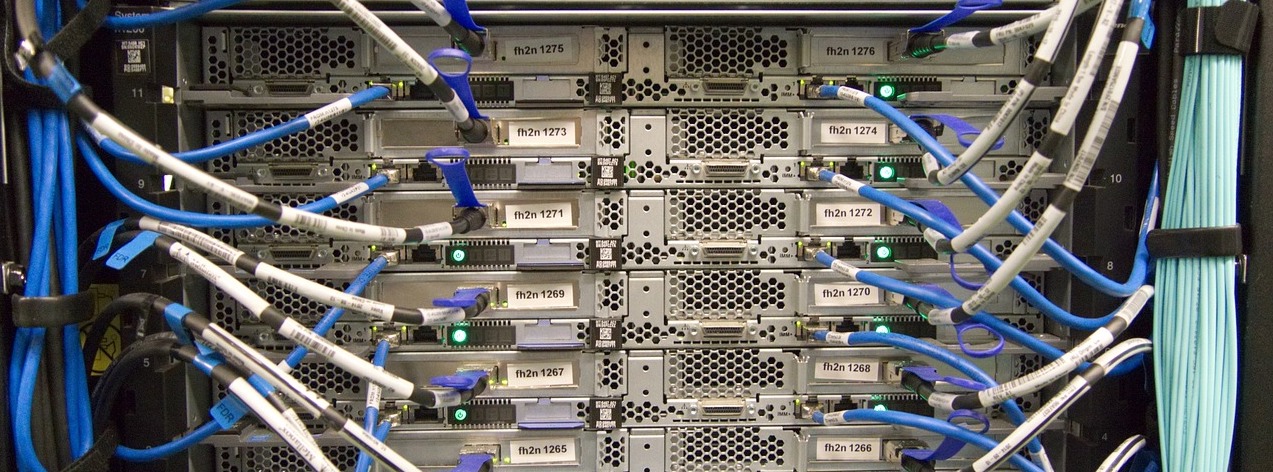

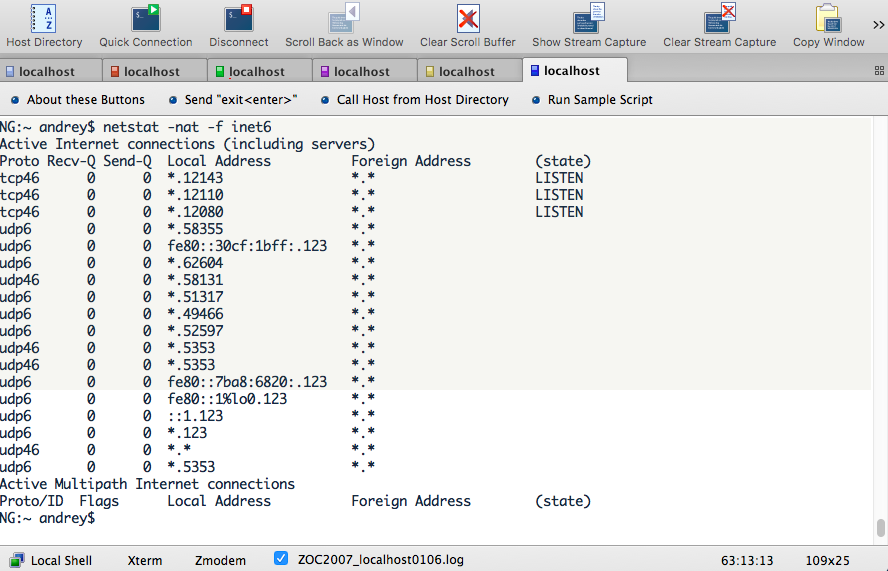

Система виртуализации kvm, созданная и работающая на хостах Linux, с точки зрения управления сильно отличается от привычной для многих VMware vSphere. При работе с ней очень многие вещи приходится делать в консоли, особенно если это продуктовые сервера. Так и установка с нуля гостевых машин с нужной операционной системой требует определенных знаний и смекалки. При этом для виртуальных машин с разными типами ОС на них нужно знать свои нюансы, чтобы получить желаемый результат. Даже разные дистрибутивы Linux требуют дифиринцированный подход. Как запилить себе одну виртуалочку с CentOS Linux 7.9 и еще одну с Ubuntu Linux 20.04 на kvm хочется показать на реальных примерах.

Ранее у себя в блоге писал уже о системе виртуализации на базе kvm — Proxmox-VE. Это были статьи — «Импорт kvm виртуалок в Proxmox» и «Небольшие лайфхаки с Proxmox«. Да, Proxmox обладает отличным графическим веб интерфейсом, имея kvm под капотом. Но зачастую kvm применяется напрямую без лишней обвязки и требует знаний по работе с ним из командой строки Linux с использованием различных утилит управления и мониторинга. С учетом того, что актуальность использования kvm в современном IT мире довольно высокая, знание специфики работы с ним будет далеко не бесполезным для администраторов и программистов.

Читать далее «Создание виртуалок в kvm из консоли»